ديب سيك تُحذر: نموذجنا R1 يصبح “أقل أمانًا” في هذه الحالات!

3 د

حذّرت "ديب سيك" من المخاطر الناتجة عن كسر الحماية لأنظمة الذكاء الاصطناعي المفتوحة.

التحذير نُشر في مجلة Nature وأثر بشكل كبير على شفافية القطاع في الصين.

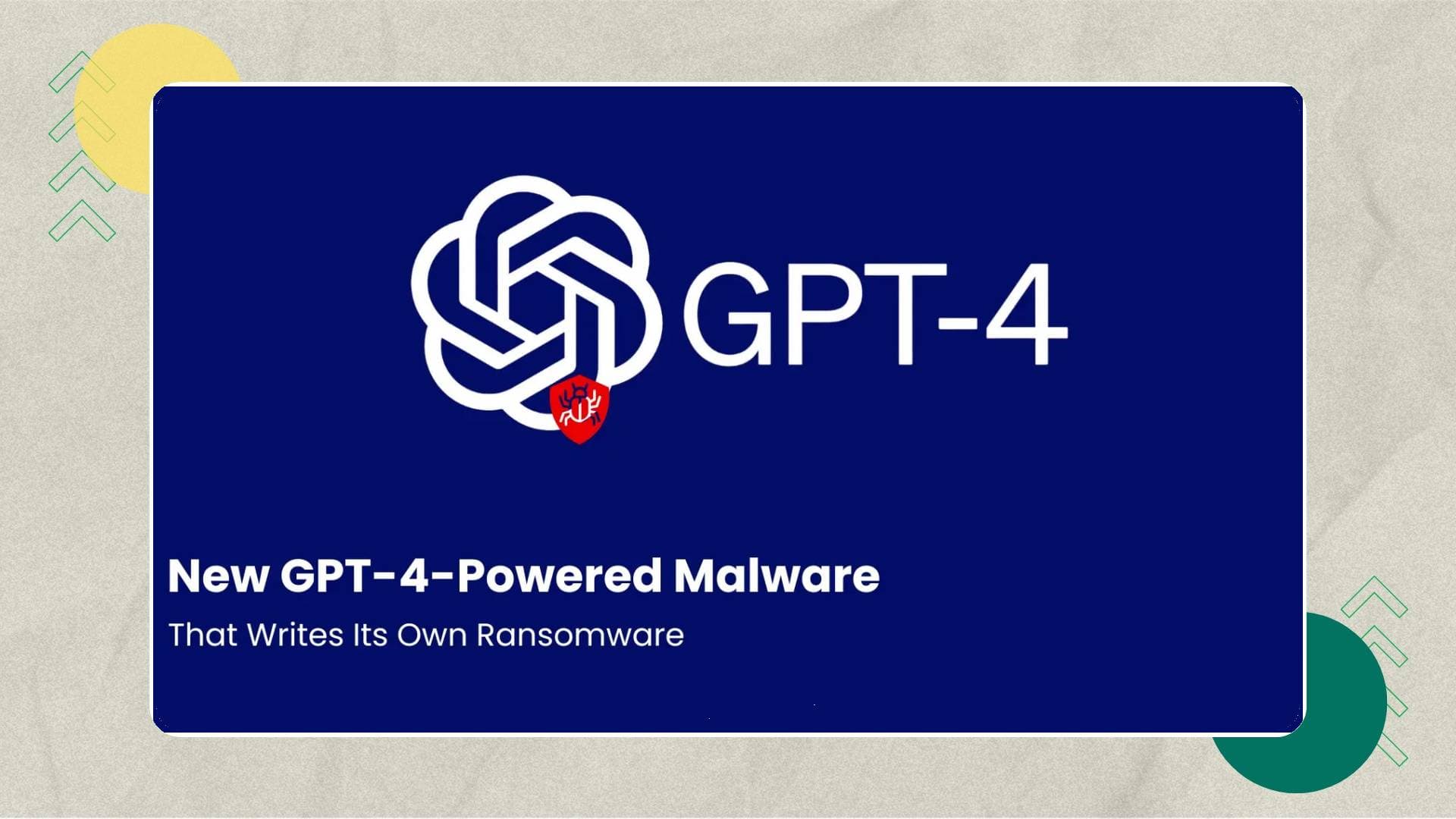

أكدت اختبارات "ديب سيك" أن كسر الحماية يقلل الأمان في النماذج مثل R1 وGPT-4o.

تدعم الحكومات والشركات الانفتاح ولكنها تحذر من احتمالات إساءة الاستخدام.

تُظهر هذه التحذيرات الحاجة إلى حوكمة واعية لحماية المجتمعات والأمن.

حذّرت شركة "ديب سيك" الصينية الناشئة، ومقرها هانغتشو، من المخاطر المتزايدة الناجمة عن كسر الحماية لأنظمة الذكاء الاصطناعي مفتوحة المصدر، مؤكدة أن هذه النماذج تتعرض لاحتمالات إساءة الاستخدام بمجرد تعطيل آليات الأمان المدمجة. التحذير أتى عبر ورقة بحثية نُشرت في مجلة Nature، وهو ما اعتُبر خطوة فارقة لقطاع التقنية في الصين على مستوى الشفافية العلمية.

نماذج مفتوحة المصدر بين الحرية والمخاطر

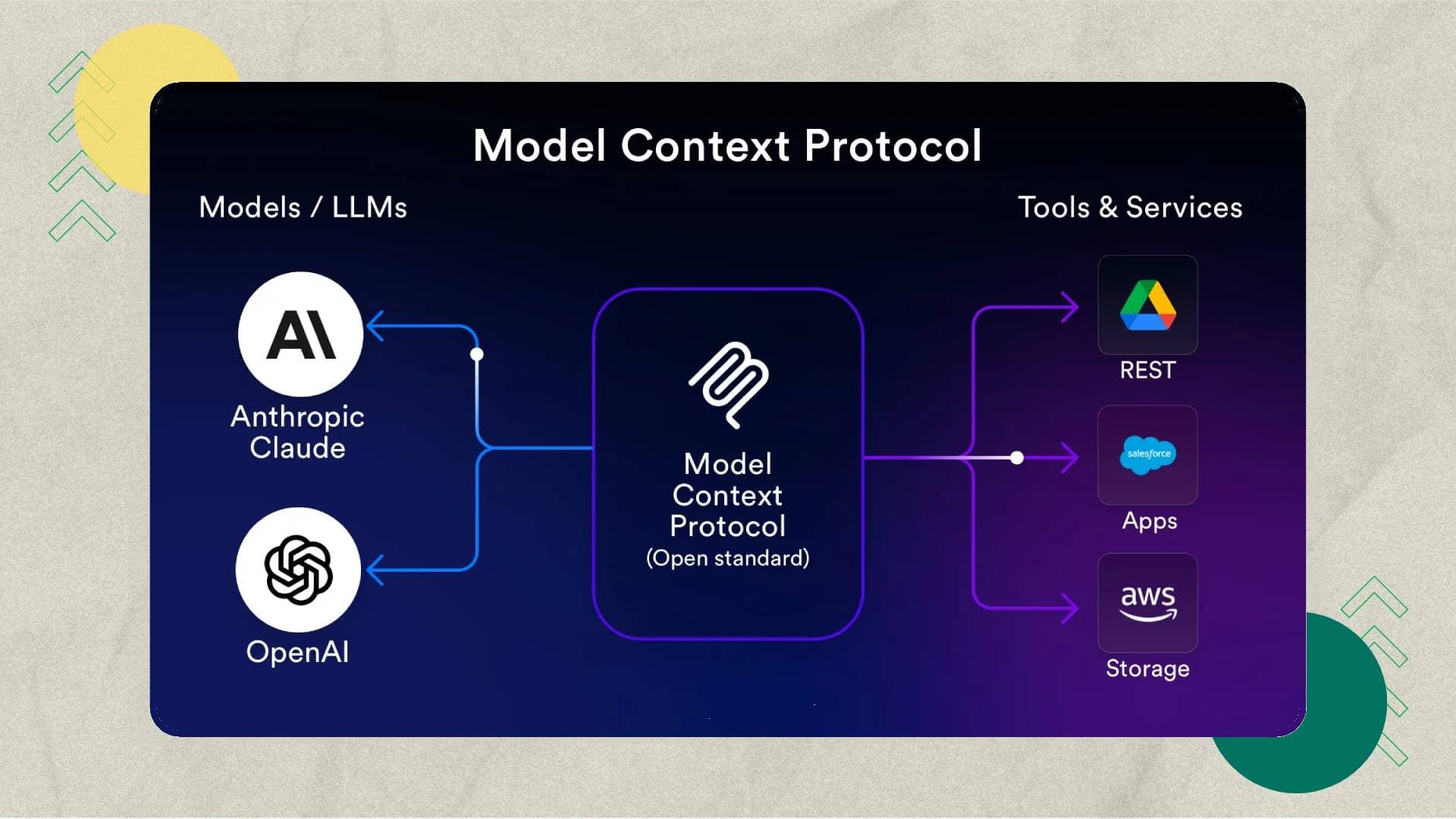

تؤكد نتائج اختبارات "ديب سيك" باستخدام فرق حمراء لمحاكاة الهجمات، أن نموذجها R1 الذي أُطلق مطلع العام الحالي يصبح "أقل أمانًا" عند إزالة الضوابط الخارجية. ولم يكن هذا النموذج وحده الذي أظهر هشاشة أمنية؛ إذ أظهرت اختبارات إضافية أن نماذج منافسة مثل GPT-4o من OpenAI وClaude-3.7 من Anthropic تسجل معدلات أعلى من الاستجابات الضارة في حال تعرّضها لكسر الحماية.

إتاحة النماذج مفتوحة المصدر على الإنترنت يفتح الباب أمام مجتمع الباحثين لتطوير تقنيات أسرع وبكلفة أقل، كما هو الحال مع تكلفة تدريب R1 التي بلغت 294 ألف دولار فقط، وهي تكلفة تقل بكثير عن استثمارات الشركات الأميركية. لكن هذا الانفتاح يحمل معه أيضًا جانبًا سلبيًا: القدرة على تعديل النماذج وإزالة القيود الأمنية بطرق قد يستغلها فاعلون خبيثون.

- انخفاض تكلفة تطوير النماذج في الصين مقارنة بالشركات الأميركية الكبرى.

- رفع معدلات الاستجابات الضارة عند كسر الحماية.

- اعتماد فرق متخصصة لمحاكاة الهجمات وتقييم قوة الأنظمة.

- مخاوف رسمية من انتقال الثغرات إلى تطبيقات مستقبلية.

تأثير التحذير على صناعة الذكاء الاصطناعي

التحذير الذي ترافق مع تنبيه رسمي من هيئة المعايير التقنية التابعة لإدارة الفضاء الإلكتروني الصيني يسلّط الضوء على نقاش متصاعد عالميًا: كيف يمكن تحقيق التوازن بين تطوير تقنيات الذكاء الاصطناعي المفتوحة وبين ضمان استخدامها بشكل آمن؟ فبينما تدعم الحكومات والشركات الانفتاح لتعزيز الابتكار، ينمو القلق من سهولة استغلال هذه النماذج لإنتاج محتوى ضار أو تطوير أنظمة خبيثة.

ظهور "ديب سيك" في منصة أكاديمية عالمية مثل Nature لم يكن حدثًا اعتياديًا، إذ يُنظر إليه باعتباره مؤشرًا على أن الشركات الصينية بدأت تنفتح على مراجعة الأقران ونشر بياناتها الأمنية، وهو ما يتماشى مع التيار العالمي لتشديد الرقابة على أنظمة الذكاء الاصطناعي. بعض المراقبين يربطون هذا التوجه مع تزايد التنافس بين الصين والولايات المتحدة على قيادة هذا القطاع.

"النماذج المفتوحة تقدم فرصًا متقدمة للبحث، لكنها تحتاج إلى حوكمة واعية لردع إساءة الاستخدام."

مقالات سابقة تتناول مستقبل الذكاء الاصطناعي ومساراته المتوقعة كانت قد أشارت إلى أن معركة التفوق التكنولوجي لا تدور فقط حول قوة النماذج، بل أيضًا حول الثقة المجتمعية والأمان. في السياق نفسه، تشير توصيات إلى أن الثغرات المكتشفة قد تنتقل بسهولة إلى الأجيال القادمة من النماذج ما لم يتم ضبطها مبكرًا.

ما الذي يعنيه ذلك للمستقبل؟

تُظهر هذه التطورات أن الذكاء الاصطناعي المفتوح يقف عند مفترق طرق: من جهة، يمنح الباحثين والشركات الناشئة القدرة على الابتكار بسرعة غير مسبوقة؛ ومن جهة أخرى، يرفع مستوى التحديات الأمنية بصورة قد تفرض أنظمة حوكمة صارمة في المستقبل القريب. المعضلة العالمية ليست في إبطاء عجلة التقدم، بل في بناء طبقات أمان متينة تتماشى مع وتيرة هذا التقدم. والسؤال الذي يظل مطروحًا: هل تستطيع الشركات والحكومات صياغة أوراق قواعد جديدة توازن بين الحرية الرقمية والأمان المجتمعي؟

ذكاء اصطناعي

ذكاء اصطناعي منصات

منصات ريادة عربية

ريادة عربية أجهزة ذكية

أجهزة ذكية هواتف

هواتف برمجة

برمجة