GPT-4 يثير القلق بإطلاقه موجة جديدة من فيروسات الفدية والهجمات الإلكترونية

3 د

كشف باحثون في أمن المعلومات عن برمجية خبيثة جديدة تُدعى MalTerminal.

اعتمدت البرمجية على واجهة OpenAI التي توقفت في نوفمبر 2023، مما يوضح قدم تطويرها.

تتضمن خيارات الهجوم أدوات فدية وقنوات وصول خفية، مظهرة تحولًا في أدوات السيبرانية.

يدمج MalTerminal نماذج لغوية جزءاً من الكود التنفيذي، تظهر توجه الهجوم يكافح الذكاء الاصطناعي.

تثير هجمات الذكاء الاصطناعي تساؤلات حول تطور الدفاعات الرقمية المستقبلية ومعايير الأمن.

كشف باحثون في أمن المعلومات عن برمجية خبيثة جديدة تُدعى MalTerminal، وُصفت بأنها من أوائل الأمثلة على دمج نماذج لغوية كبيرة (LLM) مباشرة داخل أدوات هجومية. الإعلان جاء خلال مؤتمر LABScon 2025 الأمني، بعد تحليل لملف تنفيذي على نظام ويندوز قادر على توليد شيفرة برمجية في الوقت الفعلي، إما لبرمجيات فدية أو لفتح قنوات وصول خفية (Reverse Shell).

أبعاد تقنية وجذور مبكرة للبرمجيات المدمجة بالذكاء الاصطناعي

تبيّن أن النسخة المكتشفة من MalTerminal اعتمدت على واجهة برمجة تطبيقات OpenAI التي جرى إيقافها في نوفمبر 2023، ما يشير إلى أن تطويرها أسبق من هذا التاريخ. ويُرجّح الباحثون في SentinelOne أن العينة لم تُستخدم فعليًا في هجمات واسعة، بل ربما كانت أقرب إلى أداة اختبار أو مشروع لمجموعات متخصصة في "الأمن الهجومي".

وجود ملفات إضافية مرافقة، منها سكربتات مكتوبة بلغة Python، أعطى أدلة أوضح على فكرة التصميم: توفير خيار للمستخدم بين إنشاء برمجية فدية أو قناة عكسية للتحكم بالنظام. ومن اللافت أن الحزمة تضمنت أداة دفاعية باسم FalconShield، توظّف بدورها نموذجًا لغويًا لتحليل ملفات واستخلاص تقارير شبه آلية حول احتماليتها أن تكون خبيثة.

- البرمجية مرتبطة بواجهة GPT-4 من OpenAI.

- تتضمن خيارات متعددة للهجوم (فدية أو وصول خفي).

- تاريخ تطويرها يسبق توقف واجهة برمجة التطبيقات في 2023.

- وجود أداة موازية للتحليل الدفاعي مدمجة مع الحزمة.

هذه الملاحظات تمثل تحولًا نوعيًا في أدوات الهجوم السيبراني، إذ لم تعد النماذج اللغوية أدوات مساعدة للتخطيط أو كتابة برمجية أولية، بل أصبحت جزءًا من الكود التنفيذي نفسه. ويعيد ذلك إلى الأذهان اكتشافات سابقة لبرمجيات مثل LAMEHUG وPromptLock، التي أظهرت نفس المسار: دمج الذكاء الاصطناعي كنواة داخلية للبرمجية الضارة.

هجمات أكثر تحايلاً مع إدخال الذكاء الاصطناعي

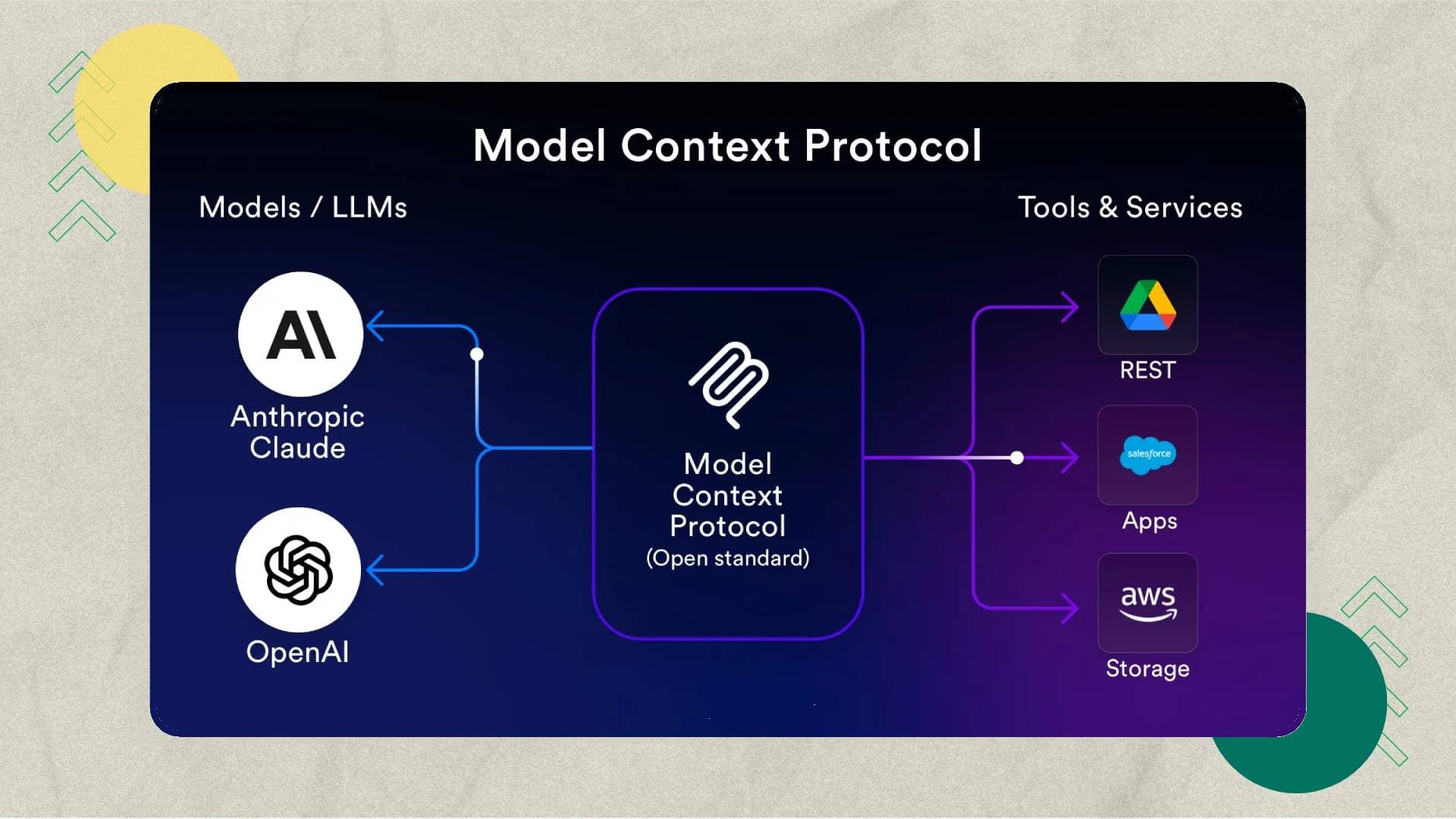

التقرير لم يتوقف عند MalTerminal، بل أشار إلى أن الحزم الخبيثة بدأت تستهدف حتى أدوات الدفاع القائمة على الذكاء الاصطناعي. وفقًا لفريق StrongestLayer، يمكن للهجوم أن يحتوي على "حقن أوامر مخفية" داخل ملفات HTML على شكل تعليمات مقنّعة للنماذج اللغوية، تُجبر آليات الكشف الآلي على اعتبار الرسائل آمنة، بالرغم من احتوائها على ملفات استغلال ثغرات مثل Follina (CVE-2022-30190).

"المهاجم كان يتحدث بلغة الذكاء الاصطناعي نفسها ليجعل أنظمتنا تتغاضى عن التهديد"، بحسب محمد رضوان، المدير التقني لشركة StrongestLayer.

خطورة هذا التوجّه تكمن في قابلية الذكاء الاصطناعي ليصبح أداة للهجوم كما هو للدفاع. في الوقت الذي تتسابق فيه المؤسسات لاعتماد أدوات توليدية في فلاتر الرسائل وتصفية المحتوى، يعمل المهاجمون على إعادة صياغة أساليبهم بحيث "يخدعون" النماذج نفسها.

ما الذي يعنيه ذلك لمستقبل الدفاعات الرقمية؟

صورة المشهد الحالية ترسّخ اتجاهًا لا يمكن تجاهله: البرمجيات الخبيثة لم تعد مجرد كود مقفل، بل أنظمة متكاملة تستدعي قدرات ذكية عند الحاجة. وبقدر ما تبدو هذه التطورات مقلقة، فإنها تفتح الباب أمام تطورات مقابلة على مستوى الدفاع، مثل تطوير نماذج أكثر وعيًا بالتحايل وإدخال "تحليل السياق" بدلًا من الاعتماد على مؤشرات تقليدية.

في وقت يشهد توسعًا لاعتماد منصات ذكاء اصطناعي عبر المؤسسات والأفراد، قد يتحول الصراع المستقبلي من سباق "قدرات هجومية" إلى سباق "تدريب إدراكي" بين نماذج ذكية بعضها يسعى لخداع الآخر. ويبقى السؤال مفتوحًا: هل يمكن لهذه المواجهة أن تدفع لظهور جيل جديد من معايير "الأمن الموجه بالذكاء" شبيه بدور التشفير في العقود الماضية؟

ذكاء اصطناعي

ذكاء اصطناعي منصات

منصات ريادة عربية

ريادة عربية أجهزة ذكية

أجهزة ذكية هواتف

هواتف برمجة

برمجة